йҷӨдәҶйҖҶеӨ©зҡ„FalconпјҢзӣ®еүҚејҖжәҗжЁЎеһӢзҡ„еҸӮж•°еҹәжң¬йғҪжҺ§еҲ¶еңЁ7B-13Bе·ҰеҸі гҖӮеӨ§жЁЎеһӢеҺӮе•Ҷе‘ҠиҜүе…үй”ҘжҷәиғҪпјҢ“зӣ®еүҚ7B-13BдәҝеҸӮж•°йҮҸжҳҜдёҖдёӘиҫғдёәеҗҲзҗҶзҡ„ејҖжәҗ规模” гҖӮиҝҷжҳҜеҹәдәҺеӨҡйҮҚеӣ зҙ жүҖеҫ—еҮәзҡ„еҸӮж•°йҮҸ规模пјҢеҰӮи®Ўз®—иө„жәҗйҷҗеҲ¶гҖҒеҶ…еӯҳйҷҗеҲ¶гҖҒејҖжәҗжҲҗжң¬иҖғйҮҸзӯү гҖӮ

йҳҝйҮҢдә‘CTOе‘Ёйқ–дәәеҹәдәҺдә‘еҺӮе•Ҷзҡ„и§’еәҰиҖғиҷ‘йҒ“пјҡ“жҲ‘们еёҢжңӣдјҒдёҡе’ҢејҖеҸ‘иҖ…пјҢеңЁдёҚеҗҢзҡ„еңәжҷҜеҸҜд»Ҙж №жҚ®иҮӘе·ұзҡ„йңҖжұӮйҖүжӢ©дёҚдёҖж ·и§„жЁЎзҡ„жЁЎеһӢпјҢжқҘзңҹжӯЈең°еә”з”ЁеңЁиҮӘе·ұзҡ„ејҖеҸ‘зҺҜеўғ гҖӮжҲ‘们жҸҗдҫӣжӣҙеӨҡеҸҜиғҪжҖ§ гҖӮ”

и°Ҳиө·дёәдҪ•ејҖжәҗеӨ§жЁЎеһӢпјҢе‘Ёйқ–дәәејәи°ғдәҶе®үе…ЁжҖ§пјҢ“жҲ‘们дёҚеҚ•еҚ•еҸӘжҳҜејҖжәҗеӨ§жЁЎеһӢпјҢжӣҙйҮҚиҰҒзҡ„жҳҜиҰҒиғҪеӨҹе‘ҲзҺ°еҮәеҗ„йЎ№жҢҮж Үзҡ„иЎЁзҺ°ж•ҲжһңпјҢеҹәдәҺжӯӨ пјҢ жүҚиғҪеӨҹи®©еӨ§е®¶еҺ»иҜ„дј°е…¶дёӯзҡ„дҪҝз”ЁйЈҺйҷ©пјҢжӣҙеҠ жңүж•Ҳең°иҝӣиЎҢжЁЎеһӢеә”з”Ё гҖӮ”

“йҮҚиҰҒзҡ„жҳҜпјҢйҡҸзқҖеҸӮж•°йҮҸзҡ„еўһеҠ пјҢжЁЎеһӢж•ҲжһңжҸҗеҚҮдјҡйҖҗжёҗ收ж•ӣ гҖӮеҪ“жЁЎеһӢиҫҫеҲ°дёҖе®ҡ规模еҗҺ пјҢ 继з»ӯеўһеҠ еҸӮж•°еҜ№ж•ҲжһңжҸҗеҚҮзҡ„иҫ№йҷ…ж•ҲзӣҠеҸӘдјҡдёӢйҷҚпјҢ70-130дәҝеҸӮж•°йҮҸдёҖиҲ¬е·Із»ҸжҺҘиҝ‘收ж•ӣзҠ¶жҖҒдәҶ гҖӮ”дёҠиҝ°еӨ§жЁЎеһӢеҺӮе•ҶйҒ“ гҖӮ

е…үй”ҘжҷәиғҪеҸ‘зҺ°пјҢйҷӨдәҶйҳҝйҮҢдә‘еңЁи§Ҷи§үиҜӯиЁҖжЁЎеһӢзҡ„з»ҶеҲҶйўҶеҹҹеҸ‘еёғдәҶејҖжәҗеӨ§жЁЎеһӢеӨ– пјҢ е…¶дҪҷе…¬еҸёзҡҶжҸҗдҫӣзҡ„жҳҜйҖҡз”ЁиғҪеҠӣзҡ„еӨ§жЁЎеһӢ гҖӮиҝҷжҲ–и®ёдёҺеӨ§жЁЎеһӢејҖжәҗд»ҚеӨ„дәҺйқһеёёж—©жңҹйҳ¶ж®өжңүе…ізі»пјҢдҪҶиҖғиҷ‘еҲ°ејҖжәҗеӨ§жЁЎеһӢд№ҹиҰҒиҗҪең°еҲ°еңәжҷҜдёӯпјҢеӨӘиҝҮдәҺеҗҢиҙЁеҢ–зҡ„йҖҡз”ЁеӨ§жЁЎеһӢеҜ№дјҒдёҡжқҘиҜҙд№ҹе®№жҳ“жІҰдёә“йёЎиӮӢ” гҖӮ

еҰӮдҪ•йҒҝе…ҚејҖжәҗеӨ§жЁЎеһӢйҮҚи№ҲиҰҶиҫҷ пјҢ дҪ“зҺ°еҮәејҖжәҗзҡ„д»·еҖјпјҢеӣһйЎҫMetaжҺҘиҝһзҘӯеҮәзҡ„“еӨ§жӢӣ”пјҢдёҖжқЎејҖжәҗзҡ„и·Ҝеҫ„дјјд№ҺйҖҗжёҗжҳҫзҺ°——жһ„е»әејҖжәҗеӨ§жЁЎеһӢз”ҹжҖҒ гҖӮ

- 2жңҲд»Ҫ пјҢ MetaеҮӯеҖҹејҖжәҗзҡ„LlamaеӨ§жЁЎеһӢеӣһеҲ°з”ҹжҲҗејҸAIж ёеҝғйҳөеҲ—пјӣ

- 5жңҲ9ж—ҘпјҢејҖжәҗдәҶж–°зҡ„AI жЁЎеһӢImageBindпјҢиҝһжҺҘж–Үжң¬гҖҒеӣҫеғҸ / и§Ҷйў‘гҖҒйҹійў‘гҖҒ3D жөӢйҮҸпјҲж·ұеәҰпјүгҖҒжё©еәҰж•°жҚ®пјҲзғӯпјүе’ҢиҝҗеҠЁж•°жҚ®е…ӯз§ҚжЁЎжҖҒпјӣ

- 5дёӘжңҲеҗҺпјҢLlama 2ејҖжәҗеҸҜе•ҶдёҡпјҢеҗ«70дәҝгҖҒ130дәҝе’Ң700дәҝдёүз§ҚеҸӮ数规模пјҢе…¶дёӯ700дәҝеҸӮж•°жЁЎеһӢиғҪеҠӣе·ІжҺҘиҝ‘GPT-3.5пјӣ

- 8жңҲ25ж—ҘпјҢMetaжҺЁеҮәдёҖж¬ҫеё®еҠ©ејҖеҸ‘дәәе‘ҳиҮӘеҠЁз”ҹжҲҗд»Јз Ғзҡ„ејҖжәҗжЁЎеһӢ——Code LlamaпјҢиҜҘд»Јз Ғз”ҹжҲҗжЁЎеһӢеҹәдәҺе…¶ејҖжәҗеӨ§иҜӯиЁҖжЁЎеһӢLlama 2пјӣ

- 8жңҲ25ж—ҘпјҢеҸ‘еёғе…Ёж–°AIжЁЎеһӢSeamlessM4TпјҢдёҺдёҖиҲ¬AIзҝ»иҜ‘еҸӘиғҪд»Һж–Үжң¬еҲ°ж–Үжң¬дёҚеҗҢпјҢиҝҷж¬ҫзҝ»иҜ‘еҷЁиҝҳиғҪеӨҹ“д»ҺиҜӯйҹіеҲ°ж–Үжң¬”жҲ–иҖ…еҸҚиҝҮжқҘ“д»Һж–Үжң¬еҲ°иҜӯйҹі”ең°зӣҙжҺҘе®ҢжҲҗзҝ»иҜ‘пјӣ

- 9жңҲ1ж—ҘпјҢе…Ғи®ёејҖжәҗи§Ҷи§үжЁЎеһӢDINOv2е•ҶдёҡеҢ–пјҢеҗҢж—¶жҺЁеҮәи§Ҷи§үиҜ„дј°жЁЎеһӢFACET гҖӮ

еҪ“е№ҙиӢұдјҹиҫҫжҺЁеҠЁGPUи®Ўз®—зҡ„ејҖжәҗеҢ– пјҢ дёҚд»…еҗёеј•дәҶеӨ§йҮҸз ”з©¶дәәе‘ҳеңЁCaffeгҖҒTensorFlowзӯүжЎҶжһ¶дёҠиҝӣиЎҢеҲӣж–°пјҢд№ҹдёәиҮӘиә«GPUдә§е“Ғз§ҜзҙҜдәҶеӨ§йҮҸдјҳеҢ–з»ҸйӘҢпјҢиҝҷдәӣз»ҸйӘҢеҗҺжқҘд№ҹеё®еҠ©иӢұдјҹиҫҫи®ҫи®ЎеҮәдәҶжӣҙйҖӮеҗҲж·ұеәҰеӯҰд№ зҡ„ж–°еһӢGPUжһ¶жһ„ гҖӮ

еҸҰдёҖж–№йқўпјҢGPUи®Ўз®—зҡ„ејҖжәҗз”ҹжҖҒи¶ҠжқҘи¶Ҡз№ҒиҚЈеҗҺпјҢд№ҹдёәе…¶еёҰжқҘдәҶе·ЁеӨ§зҡ„еёӮеңәз©әй—ҙпјҢNvidia DGXдјҒдёҡзә§зҡ„ж·ұеәҰеӯҰд№ и®ӯз»ғе№іеҸ°жҰӮеҝөеә”иҝҗиҖҢз”ҹпјҢдёәиӢұдјҹиҫҫзҡ„жҳҫеҚЎе’Ңе№іеҸ°й”Җе”®еҲӣйҖ дәҶеҚғдәҝзә§еёӮеңә гҖӮ

еӣҪеҶ…йҳҝйҮҢдә‘д№ҹеңЁйҖҡиҝҮе»әи®ҫе®Ңе–„з”ҹжҖҒзҡ„ж–№ејҸпјҢиҜ•еӣҫеё®еҠ©ејҖеҸ‘иҖ…жӣҙеҘҪзҡ„з”ЁеҘҪеӨ§жЁЎеһӢпјҢжҚ®е‘Ёйқ–дәәд»Ӣз»Қ пјҢ зӣ®еүҚйҳҝйҮҢдә‘дёҚд»…жңүиҮӘз ”ејҖжәҗеӨ§жЁЎеһӢпјҢд№ҹжҺҘе…ҘдәҶи¶…иҝҮ100дёӘејҖжәҗжЁЎеһӢпјҢеҗҢж—¶жү“йҖ дәҶејҖжәҗзӨҫеҢәйӯ”жҗӯпјҢжӣҙеҘҪең°жңҚеҠЎејҖеҸ‘иҖ…е’ҢдјҒдёҡз”ЁжҲ·пјҢз”ЁеҘҪгҖҒи°ғеҘҪеӨ§жЁЎеһӢ гҖӮ

ејҖжәҗй—ӯжәҗдёҚзҹӣзӣҫпјҢжҳҜжүӢж®өиҖҢйқһзӣ®зҡ„жҚ®еӨ–еӘ’зҲҶж–ҷпјҢMetaжӯЈеңЁеҠ зҙ§з ”еҸ‘е…Ёж–°зҡ„ејҖжәҗеӨ§жЁЎеһӢпјҢж”ҜжҢҒе…Қиҙ№е•Ҷз”ЁпјҢиғҪеҠӣеҜ№ж ҮGPT-4 пјҢ еҸӮж•°йҮҸжҜ”Llama 2иҝҳиҰҒеӨ§дёҠж•°еҖҚпјҢи®ЎеҲ’еңЁ2024е№ҙеҲқејҖе§Ӣи®ӯз»ғ гҖӮ

еӣҪеӨ–еӨ§жЁЎеһӢж јеұҖзңӢдјјжҳҜOpenAI“дёҖи¶…еӨҡејә” пјҢ е®һеҲҷжҳҜдј—еӨҡе…¬еҸёзҺҜдјәпјҢеҸҜд»Ҙйў„и§ҒпјҢејҖжәҗеӨ§жЁЎеһӢеҜ№й—ӯжәҗзҡ„еӣҙеүҝпјҢи¶ҠжқҘи¶ҠжӯҘжӯҘзҙ§йҖј гҖӮ

ж–Үз« жҸ’еӣҫ

еӣҪеӨ–дёҖд»Ҫз ”з©¶жҠҘе‘Ҡз§° пјҢ еӨ§жЁЎеһӢеүҚжңҹзҡ„еҸ‘еұ•еҲӣж–°з”ұOpenAIгҖҒеҫ®иҪҜгҖҒи°·жӯҢзӯүеӨ§е…¬еҸёй—ӯжәҗжЁЎеһӢдё»еҜјпјҢдҪҶи¶ҠеҲ°еҗҺжңҹејҖжәҗжЁЎеһӢе’ҢзӨҫеҢәзҡ„иҙЎзҢ®еҖје°ұи¶ҠеӨ§ гҖӮ

е…үй”ҘжҷәиғҪд№ҹдәҶи§ЈеҲ°пјҢеңЁеӣҪеҶ…ејҖжәҗеӨ§жЁЎеһӢд№ҹжҲҗдёәдәҶдјҒдёҡзҡ„“ж–°еҚ–зӮ№”пјҢжңүдјҒдёҡз”ҡиҮійҖҡиҝҮеҜ№еӨ–е®Јз§°е·ІдҪҝз”ЁдәҶ“еҸІдёҠжңҖејәеӨ§жЁЎеһӢFalcon 180B”пјҢжқҘеұ•зҺ°е…¶еә•еұӮжЁЎеһӢжҠҖжңҜиғҪеҠӣзҡ„ејәеӨ§пјҢйЎ¶зқҖ“еҸІдёҠжңҖејә”зҡ„з§°еҸ·пјҢеҸҲ收еүІдәҶ“дёҖжіўйҹӯиҸң” гҖӮ

зҺ°йҳ¶ж®өпјҢејҖжәҗеӨ§жЁЎеһӢе·Із»ҸиҜҒжҳҺдәҶеҮ зӮ№йҮҚиҰҒзҡ„дәӢе®һ гҖӮ

йҰ–е…ҲпјҢеңЁйқһеёёеӨ§зҡ„ж•°жҚ®йӣҶдёҠиҝӣиЎҢи®ӯз»ғпјҢжӢҘжңүеҮ еҚҒдәҝдёӘеҸӮж•°зҡ„еӨ§жЁЎеһӢеңЁжҖ§иғҪдёҠе°ұеҸҜд»ҘдёҺи¶…еӨ§и§„жЁЎеӨ§жЁЎеһӢзӣёеӘІзҫҺпјӣе…¶ж¬Ў пјҢ еҸӘйңҖиҰҒжһҒе°‘зҡ„йў„з®—гҖҒйҖӮйҮҸзҡ„ж•°жҚ®д»ҘеҸҠдҪҺйҳ¶йҖӮеә”пјҲLow-rank adaptationпјҢLoRAпјүзӯүжҠҖжңҜе°ұеҸҜд»ҘжҠҠе°ҸеҸӮж•°зҡ„еӨ§жЁЎеһӢи°ғеҲ°дёҖдёӘж»Ўж„Ҹзҡ„ж•Ҳжһң пјҢ дё”е°Ҷи®ӯз»ғжҲҗжң¬йҷҚдҪҺдәҶдёҠеҚғеҖҚ гҖӮејҖжәҗеӨ§жЁЎеһӢдёәзҺ°еңЁзҡ„дјҒдёҡжҸҗдҫӣдәҶй—ӯжәҗзҡ„жӣҝд»Јж–№жЎҲпјҢдҪҺжҲҗжң¬жҲҗдёәжңҖеҗёеј•д»–们зҡ„ең°ж–№пјӣжңҖеҗҺпјҢжҲ‘们д№ҹзңӢеҲ°ејҖжәҗеӨ§жЁЎеһӢзҡ„еҸ‘еұ•йҖҹеәҰд№ҹиҝңеҝ«дәҺе°Ғй—ӯз”ҹжҖҒзі»з»ҹ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- AIеӨ§жЁЎеһӢдёӢдёҖжӯҘжҖҺд№Ҳиө°пјҹзҷҫеәҰдё–з•Ңдә”еӨ§дә®зӮ№з»ҷеҮәиЎҢдёҡйЈҺеҗ‘ж Ү

- LLM и§ЈиҜ»еӨ§жЁЎеһӢзҡ„token

- з”ҹжҲҗејҸAIдёҺеӨ§жЁЎеһӢжңүд»Җд№ҲеҢәеҲ«е’ҢиҒ”зі»пјҹ

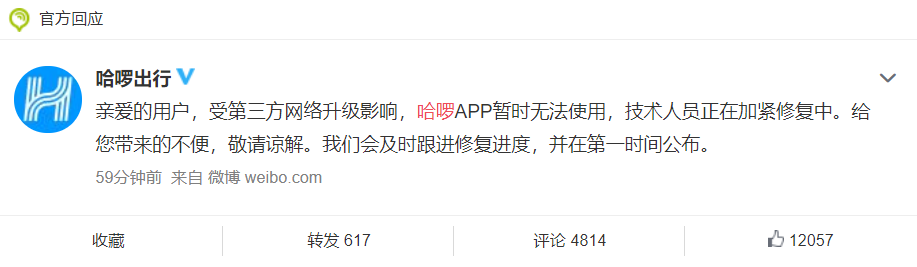

- зҪ‘жӣқеҗҙеҘҮйҡҶе’ҢеҲҳиҜ—иҜ—е®ҳе®ЈзҰ»е©ҡпјҹеӣӣзҲ·е®ҳж–№еӣһеә”жқҘдәҶпјҢжӯЈеңЁиө°жі•еҫӢйҖ”еҫ„

- 8дёӘиЎЁзҺ°иҜҙжҳҺдҪ жӯЈеңЁеҸҳзҳҰ

- ејҖжәҗжЎҶжһ¶дёӯзҡ„иҙЈд»»й“ҫжЁЎејҸе®һи·ө

- жҸӯз§ҳеӨ§жЁЎеһӢиғҢеҗҺзҡ„зҹҘиҜҶеӮЁеӯҳдёҺжҸҗеҸ–жҠҖжңҜ

- еӨ§жЁЎеһӢеҠ©еҠӣй«ҳж•ҲеҲӣе»әзҹҘиҜҶеӣҫи°ұ

- еҰӮдҪ•жһ„е»әеҹәдәҺеӨ§жЁЎеһӢзҡ„App

- дәәе·ҘжҷәиғҪеӨ§жЁЎеһӢеёғеұҖеҚғиЎҢзҷҫдёҡ